Large Language Model (LLM) Engineering

Приступаем к копанию темы и сбору материалов.

Будет кому интересно, сделаем репо публичным.

[Book] [Sebastian Raschka] Build a Large Language Model (From Scratch) [ENG, 2024]

На просторах интернетов найдена книга и видео к книге на 17 часов. Сам автор рассказывает и показывает что да как. Бум копать и присматриваться. М.б. кто присоединится.

github:

https://github.com/rasbt/LLMs-from-scratch

Планы по изучению и применению LLM в организации

Интересует возможность дообучить модель технологического гиганта приватными (но не представляющими особой секретности) данными нашей компании, чтобы ответы по возникающим вопросам можно было получить быстрее и меньше отвлекать специалистов, занятых другими задачами.

Если у вас +/- аналогичные интересы, давайте коммуницировать, обмениваться информацией и наработками.

Телеграм группа:

https://t.me/matematika_org/

Что понадобится для создание собственной LLM с 0

Создание собственной языковой модели (LLM, от англ. “Large Language Model”) с нуля — это сложная задача, требующая больших вычислительных ресурсов, специализированных знаний в области машинного обучения, а также хорошего понимания обработки естественного языка. Вот основные шаги и компоненты, которые вам понадобятся:

- Сбор и подготовка данных:

- Датасет: Вам нужны большие объемы текстовых данных. Источники могут включать книги, вики, интернет-страницы и различные корпуса текстов. Данные должны быть очищены и предварительно обработаны.

- Аннотация данных (опционально): Для некоторых задач может понадобиться аннотация данных, например, для обучения модели специфическим навыкам.

- Написание или использование готовой архитектуры модели:

- Вам понадобится определиться с архитектурой модели. Большинство современных LLM основаны на архитектуре трансформеров. Примеры: GPT (Generative Pre-trained Transformer), BERT (Bidirectional Encoder Representations from Transformers).

- Вы можете использовать существующие библиотеки и фреймворки, такие как Hugging Face Transformers, PyTorch, TensorFlow, которые предоставляют уже готовые реализации популярных архитектур.

- Настройка и обучение модели:

- Вычислительные ресурсы: Для обучения понадобится доступ к мощным графическим процессорам (GPU) или даже специализированным ускорителям, таким как TPUs от Google.

- Гиперпараметры: Вам необходимо будет выбрать гиперпараметры модели, такие как количество слоев, размер скрытого слоя, количество голов в механизме внимания и т. д.

- Обучение модели: Процесс может занять много времени, в зависимости от сложности модели и объема данных.

- Тестирование и валидация:

- Вам нужно будет разделить данные на обучающую, валидационную и, возможно, тестовую выборки.

- Оцените качество модели на валидационной выборке, используя такие метрики, как Perplexity для задач генерации текста.

- Оптимизация и дообучение:

- После начального обучения можно проводить дальнейшую донастройку модели на специализированных данных для улучшения производительности в конкретных задачах или областях.

- Ресурсы и документация:

- Освойте основные концепции и методы NLP и DL, изучая соответствующие научные статьи и документацию к используемым библиотекам.

- Полезно следить за исследованиями и статьями, чтобы быть в курсе передовых методик и подходов.

- Развертывание и интеграция:

- После успешного обучения и тестирования модели, следующий шаг — развертывание и внедрение модели в практическое приложение или сервис.

- Этические аспекты и безопасность:

- Убедитесь, что модель не генерирует вредоносные, токсичные или предвзятые тексты. Регулярно оценивайте и улучшайте модель с этической точки зрения.

Помните, что создание LLM с нуля требует значительных усилий, поэтому вы можете рассмотреть возможность донастройки существующих моделей, чтобы значительно сократить время и ресурсы, необходимые для построения вашей системы.

[VideoCourse][Zerotomastery] AI Engineering Bootcamp: Retrieval Augmented Generation (RAG) for LLMs [ENG, 2025]

https://zerotomastery.io/courses/ai-engineer-bootcamp-retrieval-augmented-generation/

[YouTube][Aleksandar Haber PhD] RAGFlow with Local LLMs and Ollama: Step-by-Step Guide for Free Retrieval-Augmented Generation [ENG, 2025]

[YouTube][Aleksandar Haber PhD] Run DeepSeek-R1 on Raspberry Pi Locally and Securely with Graphics User Interface-Step by Step Guide [ENG, 2025]

[YouTube][Aleksandar Haber PhD] Easiest Local and Private Installation of DeepSeek-R1 with Graphics User Interface in Browser [ENG, 2025]

[YouTube][Aleksandar Haber PhD] Run Distilled DeepSeek-R1 with Graphics User Interface Locally and Privately on Windows [ENG, 2025]

[Videos][Paulo] DeepSeek R1 & Ollama Guide: Build Local AI Applications [ENG, 2025][1h 43m]

[YouTube][Aleksandar Haber PhD] Correctly Install and Run RAGFlow Locally with Llama/Ollama and Create Local Knowledge Base and Chat [ENG, 2024]

Записал команды, чтобы не поить автора кофеином

[YouTube][freeCodeCamp.org] LLM Course – Build a Semantic Book Recommender (Python, OpenAI, LangChain, Gradio) [ENG, 2025]

https://github.com/t-redactyl/llm-semantic-book-recommender/tree/main

[YouTube][freeCodeCamp.org] Ollama Course – Build AI Apps Locally [ENG, 2024]

[Book][Manning][Christopher Brousseau and Matthew Sharp] LLMs in Production [ENG, 2024]

GitHub

https://github.com/IMJONEZZ/LLMs-in-Production

[VideoCourse][Zerotomastery] [Daniel Bourke] Learn Hugging Face by Building a Custom AI Model [ENG, 2024]

WebSite

https://learnhuggingface.com/

GitHub

https://github.com/mrdbourke/learn-huggingface

[VideoCourse][Sinan Ozdemir][O’Reilly] Practical Retrieval Augmented Generation (RAG) [ENG, 2024.11]

https://www.oreilly.com/library/view/practical-retrieval-augmented/9780135414378/

GitHub

https://github.com/sinanuozdemir/oreilly-retrieval-augmented-gen-ai/tree/main

- Vector database (Походу не вариант)

https://www.pinecone.io/

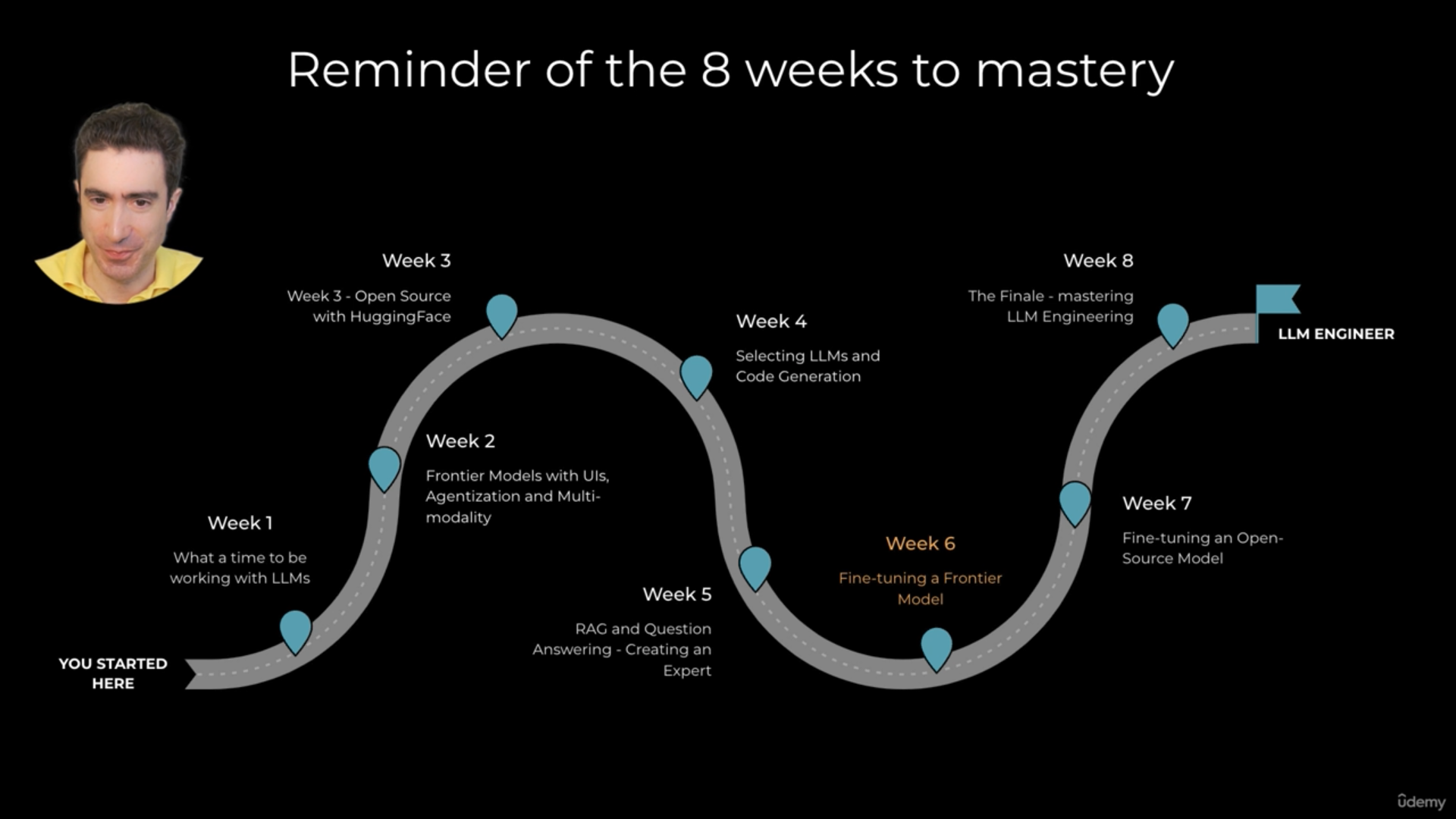

[VideoCourse][Udemy] LLM Engineering Master AI & Large Language Models (LLMs) [ENG, 2024.11]

GitHub

https://github.com/ed-donner/llm_engineering

- Сравнение моделей

https://lmarena.ai/

эл.почта: